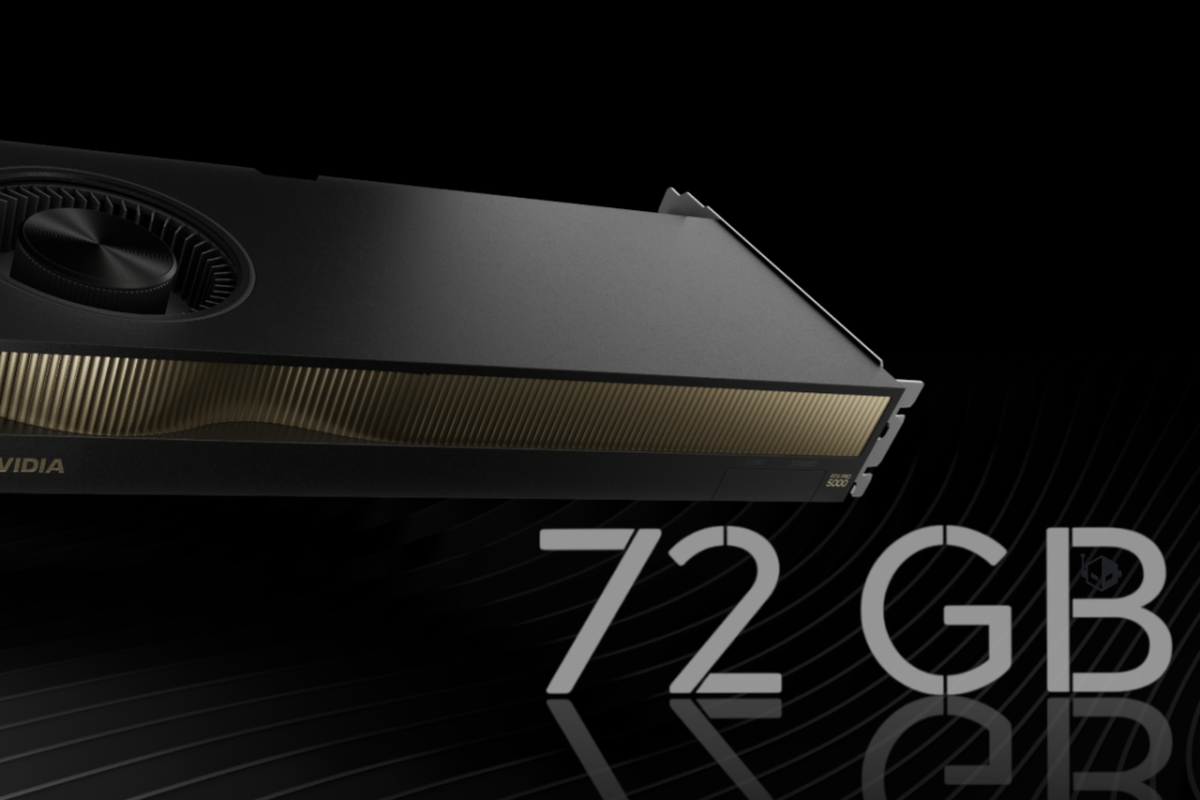

Nvidia kembali mengasah tajinya di arena komputasi kecerdasan buatan. Setelah meluncurkan GPU AI RTX Pro 5000 Blackwell pada Maret lalu, perusahaan asal Amerika Serikat itu kini memperkenalkan pembaruan signifikan yang berfokus pada satu aspek krusial: kapasitas memori. Langkah ini menjadi sinyal bahwa kebutuhan AI modern tak lagi sekadar soal kecepatan, melainkan juga soal ruang bernapas bagi data.

Pada versi awal, RTX Pro 5000 Blackwell hadir dengan video memory (VRAM) 48 GB berbasis GDDR7, yang diposisikan untuk memenuhi kebutuhan komputasi AI di segmen menengah profesional. Kini, Nvidia menaikkan kapasitas tersebut hingga 72 GB, atau sekitar 50 persen lebih besar dari konfigurasi sebelumnya. Peningkatan ini menjadikan GPU tersebut semakin relevan di tengah melonjaknya beban kerja AI yang kian rakus memori.

Untuk mencapai kapasitas 72 GB, Nvidia menambah jumlah modul memori dari 16 menjadi 24 modul GDDR7. Meski jumlah chip memori bertambah, kecepatan transfer data tetap dipertahankan di angka 28 Gbps. Artinya, Nvidia memilih menambah “volume wadah” tanpa mengubah “laju aliran”, sebuah strategi yang menitikberatkan stabilitas dan efisiensi.

Menurut Nvidia, penambahan VRAM ini dirancang khusus untuk menjawab kebutuhan komputasi AI generatif, agentic AI, serta berbagai workflow profesional kelas berat seperti rendering, simulasi, hingga inferensi model bahasa besar atau large language model (LLM). Dengan kapasitas memori yang lebih lapang, pengguna dapat menjalankan model berukuran besar tanpa terhambat bottleneck, kondisi di mana kinerja sistem tercekik akibat keterbatasan memori.

Meski mengalami lonjakan kapasitas VRAM, fondasi teknis GPU ini tetap sama. RTX Pro 5000 Blackwell 72 GB masih mengandalkan inti GPU GB202 dengan 14.080 CUDA Cores. Performa AI-nya diklaim mampu mencapai 2.142 TOPS (triliun operasi per detik), didukung antarmuka memori 384-bit dan bandwidth hingga 1,34 TB/s. Konsumsi daya pun tak berubah, dengan TDP maksimum di angka 300 watt.

Dari sisi desain fisik, Nvidia juga tidak melakukan perubahan. Kartu grafis ini tetap menggunakan sistem pendingin udara dua slot (dual-slot air-cooled), menandakan bahwa peningkatan memori tidak menuntut solusi termal yang lebih ekstrem.

Dalam hal performa, Nvidia mengklaim peningkatan yang cukup mencolok. Untuk tugas generasi gambar berbasis AI, GPU ini disebut mampu memberikan performa hingga 3,5 kali lebih cepat dibandingkan generasi sebelumnya. Sementara itu, generasi teks mengalami peningkatan hingga 2 kali lipat, dan inferensi LLM diklaim meningkat sekitar 2,1 kali.

Di ranah aplikasi profesional, dampaknya juga terasa signifikan. Pada software seperti Arnold, Chaos V-Ray, Blender, serta GPU renderer real-time seperti D5 Render dan Redshift, waktu pemrosesan diklaim dapat dipangkas hingga 4,7 kali lebih cepat. Hasilnya, proses kreatif dan simulasi kompleks yang sebelumnya memakan waktu lama kini dapat diselesaikan dengan lebih efisien.

Sebagaimana dirangkum KompasTekno dari Wccftech, GPU AI Nvidia RTX Pro 5000 Blackwell 72 GB sudah mulai tersedia melalui sejumlah produsen mitra Nvidia sejak pekan ini. Namun, Nvidia masih menyimpan rapat informasi harga, sehingga nilai jual resmi produk ini belum diumumkan ke publik.

Menariknya, pembaruan ini menjadi yang pertama di lini RTX Pro Blackwell Series yang hanya berfokus pada peningkatan kapasitas VRAM. Sebelumnya, Nvidia belum pernah melakukan penyegaran memori pada model terbaru di seri ini. Langkah tersebut dinilai sebagai upaya Nvidia untuk mempersempit jarak antara lini menengah dan kelas atas dalam keluarga RTX Pro Blackwell.

Sebagai catatan, RTX Pro 5000 sebelumnya berada di posisi tengah dengan VRAM 48 GB, sementara model flagship RTX Pro 6000 hadir dengan kapasitas memori jauh lebih besar, yakni 96 GB. Dengan hadirnya varian 72 GB, jarak antarkelas menjadi lebih proporsional.

Berbagai laporan juga menyebut bahwa strategi peningkatan VRAM ini berpotensi diterapkan Nvidia ke segmen lain di masa mendatang, termasuk GPU konsumen generasi RTX 50 Super. Langkah tersebut sejalan dengan realitas industri, di mana kebutuhan AI dan komputasi berat terus tumbuh, menuntut perangkat keras yang tidak hanya cepat, tetapi juga luas dalam menampung data.